Künstliche Intelligenz (KI) gewinnt in allen Lebensbereichen immer mehr an Beliebtheit. Es ist daher nicht verwunderlich, dass sie auch im Gesundheitswesen immer präsenter wird. In der Medizin wird es bereits in einem breiten Spektrum eingesetzt: von der Unterstützung bei der Erstellung von Krankenakten über Diagnosen [2] und die Entdeckung neuer Medikamente [3] bis hin zu Forschungsüberprüfungen, Aufklärung, Kommunikation mit dem Patienten, Unterstützung bei der Therapie [1] und der Bereitstellung personalisierter therapeutischer Vorschläge [5].

In diesem Artikel analysieren wir die wichtigsten Unterschiede zwischen einem Arzt und einer KI — nicht um sie zu bewerten, sondern um zu verstehen, wie effektiv mit Technologie zusammengearbeitet werden kann, während gleichzeitig die volle Verantwortung, die Patientenbeziehung und die Patientensicherheit gewahrt bleiben.

In der öffentlichen Debatte wird KI oft als ein einziges Phänomen behandelt. Tatsächlich handelt es sich dabei um ein breites Spektrum an Tools — von einfachen Textassistenten bis hin zu fortschrittlichen klinischen Modellen, die einer strengen Validierung unterzogen wurden. KI ist eine allgemeine Kategorie von Technologien, mit denen neue Inhalte erstellt werden können - Text, Bild, Ton, Video, Code. Unter ihnen unterscheiden wir unter anderem [8]:

In der Medizin dominieren jedoch zwei Haupttypen von KI-Modellen:

Ein Beispiel für Sprachmodelle, die im Gesundheitswesen verwendet werden, ist Med-Palm von Google, das sich auf die Beantwortung komplexer medizinischer Fragen und die Synthese von Informationen aus Text- und Bilddaten wie Röntgenbildern spezialisiert hat.

Was die zweite Gruppe betrifft - analytische Modelle -, werden sie für die bildgebende Diagnostik verwendet. Dabei handelt es sich um spezialisierte KI-Modelle (die häufig auf Deep Learning basieren), die medizinische Bilder (z. B. Röntgen, CT, MRT, Ultraschall) mit einer Präzision analysieren können, die mit der von klinischen Experten vergleichbar oder besser ist. Ein Beispiel ist das von der UCLA [9] entwickelte SliVit-Modell, das 3D-Bilder verschiedener Modalitäten und Modelle analysiert, die zur automatischen Klassifizierung und Erkennung von Läsionen anhand von Bildern verwendet werden (z. B. in der Radiologie, Dermatologie, Pathomorphologie, Kardiologie).

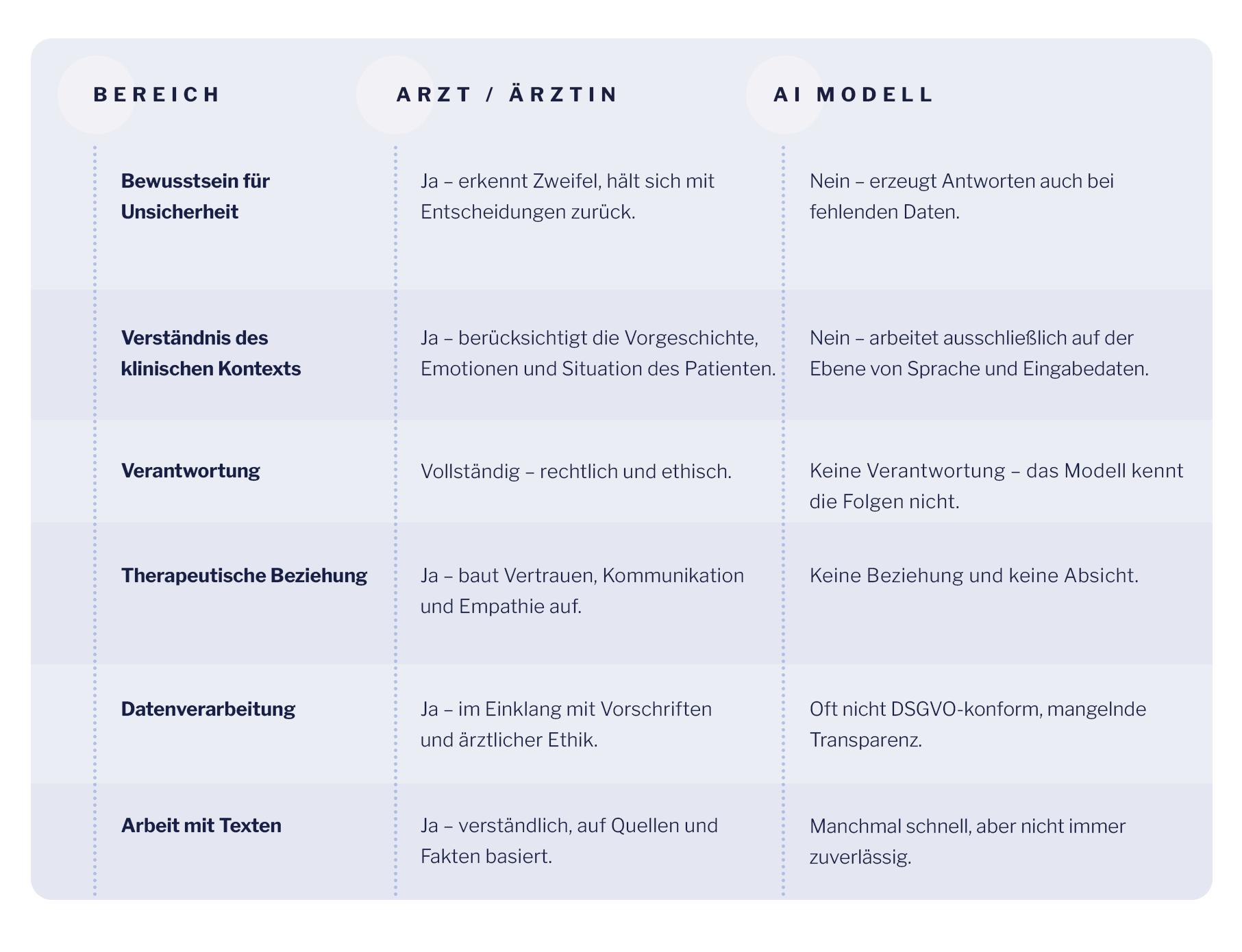

Im Gegensatz zum Arzt verstehen KI-Modelle die Bedeutung ihrer eigenen Antworten nicht - sie arbeiten nur mit statistischen Mustern. Einer der grundlegendsten Unterschiede zwischen einem Arzt und KI-Systemen ist genau die Fähigkeit Metakognitionen - Bewusstsein der eigenen Unwissenheit. Der Arzt kennt seine Verantwortung. Er weiß, dass jede klinische Entscheidung Konsequenzen hat — nicht nur medizinische, sondern auch menschliche, relationale und rechtliche. KI hat dieses Bewusstsein nicht. Er kennt den Patienten nicht, er versteht den Kontext nicht, er weiß nicht, wann er „Ich weiß nicht“ sagen soll.

KI-Systeme — auch wenn sie die Antwort nicht kennen — werden sie immer mit voller Überzeugung generieren, ohne Unsicherheit zu signalisieren. Dies führt zu den sogenannten. Halluzinationen [7] - Erstellung von Inhalten, die glaubwürdig klingen, aber völlig falsch sind. Halluzination ist kein absichtlicher Fehler, sondern eine Folge der Modellkonstruktion. Eine Lücke in den Daten reicht aus, damit das System die fehlenden Elemente „beweisen“ kann — indem es Studien, Protokolle oder Quellen erfindet.

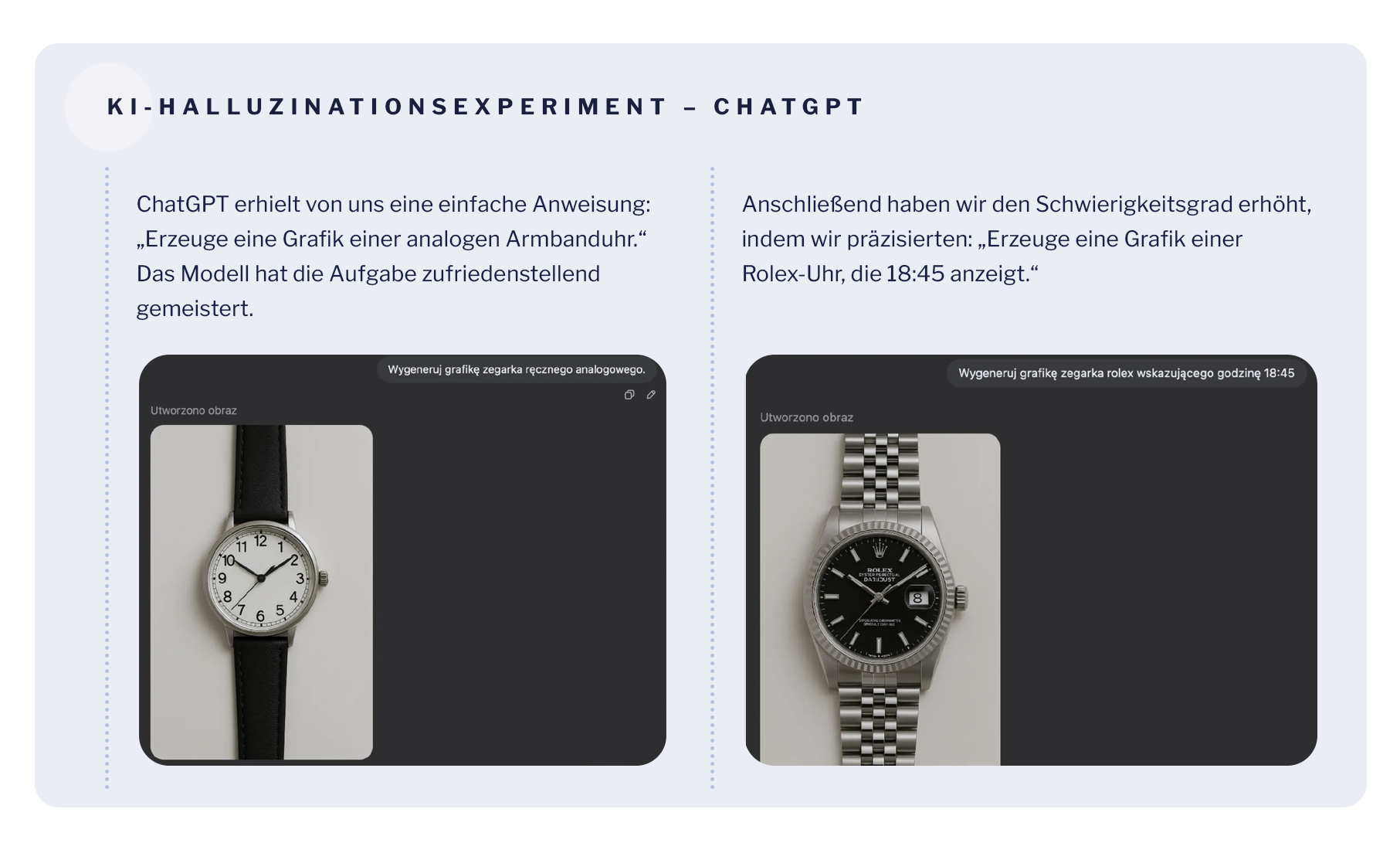

Untersuchungen deuten darauf hin, dass Sprachmodelle wie GPT-4 getrost nicht existierende Quellen zitieren, Forschungen erfinden oder unverifizierte Daten liefern können [7]. Dies wurde im Experiment zur Generierung von Uhrenbildern ausführlich veranschaulicht. Wir haben einen einfachen Test in einem der beliebtesten Sprachmodelle — ChatGPT — durchgeführt, um zu sehen, wie dieses Tool mit der Ausführung des Basisbefehls zurechtkommt. Hier sind die Ergebnisse unseres Tests:

Dabei zeigte sich ein typisches Problem von Sprachmodellen: Sie antworten mit absoluter Sicherheit, auch wenn sie falsch sind, ohne Zweifel zu signalisieren.

Dies ist ein Bildexperiment, aber ein analoger Mechanismus funktioniert bei der Generierung medizinischer Inhalte — das Modell kann nicht existierende Verfahren oder Studien mit ebenso viel Selbstvertrauen „erfinden“. In der Medizin, wo falsches Selbstvertrauen gefährlich sein kann, es stellt eine ernsthafte Bedrohung dar. Dies kann besonders schädlich sein, wenn falsche Informationen die therapeutischen Entscheidungen des Arztes beeinflussen und der Patient nicht über die Instrumente verfügt, um sie zu überprüfen [7].

Daher sollte KI als ein Instrument betrachtet werden, das die bewusste Kontrolle und Vorsicht von Ihnen als Arzt erfordert — als aktiver, verantwortungsbewusster Anwender, der weiß, wann er misstrauen muss, und jeden Vorschlag oder jede Information überprüfen kann.

KI-Modelle analysieren Daten, kennen aber nicht den Kontext, in dem Ihr Patient lebt. Sie berücksichtigen nicht familiäre Beziehungen, emotionale Herausforderungen, persönliche Geschichten oder Kontaktnuancen. Sie sehen keinen Mann - sie sehen nur den Code.

Sie haben Zugriff auf mehr als nur Daten: Beziehungen, Gespräche, Erfahrungen. Es ist der relationale Kontext, der für die klinische Entscheidungsfindung entscheidend sein kann — und der nicht vollständig auf den Algorithmus übertragen werden kann.

KI versteht keine Situation, in der ein Patient sagt „nichts funktioniert mehr“ oder „Ich fürchte, es ist Krebs“. Du — ja. Sie sehen die Reaktionen der Patienten, ihre Gesichtsausdrücke, Mikrointeraktionen. Sie kennen ihre Vorgeschichte, daher ist es einfacher zu erkennen, wenn sie sich aufgrund der Diagnose ängstlich, verängstigt oder verängstigt fühlen.

Selbst wenn KI relevante Vorschläge generiert, ist sie niemals für deren Folgen verantwortlich — rechtlich, ethisch, professionell.

Sie sind es, der der Autor der Entscheidung bleibt, unabhängig davon, welches Tool Sie verwendet haben, KI kennt die Konsequenzen ihrer „Antworten“ nicht. Er nimmt nicht an dem Gespräch mit dem Patienten teil. KI ist nur ein Instrument, keine Einheit, die in der Lage ist, die Konsequenzen ihrer „Entscheidungen“ zu tragen.

Daher kann KI Ihr Assistent sein - aber Sie sind es, der beim Patienten anwesend ist und die Verantwortung für diese Beziehung trägt.

Die Beziehung zwischen Arzt und Patient basiert auf Vertrauen. Es geht nicht nur um Kompetenz, sondern auch um Präsenz, Achtsamkeit und Empathie — gerade in Situationen der Unsicherheit. Die KI kann zwar in einem Text Freundlichkeit simulieren, reagiert aber nicht auf Stille, bemerkt keine gebrochene Stimme oder greift ein Thema auf, das für den Patienten schwer auszusprechen ist.

Sie schaffen eine Atmosphäre, die dem Patienten ein Gefühl der Sicherheit gibt. KI hat keine Absicht, kein Gefühl oder keine relationale Verantwortung.

Sprachmodelle können Text sofort generieren. Die meisten generativen Anwendungen der KI im Gesundheitswesen basieren jedoch auf Modellen, deren Daten auf ungefilterten Internetdaten basieren [6]. Das bedeutet, dass die Modelle nicht wissen, ob das, was sie zitieren, aus einer realen Quelle stammt. Sie sind sich nicht bewusst, dass etwas ungenau, veraltet oder einfach nicht existiert.

Sie, die KI verwenden, um Inhalte zu erstellen — zum Beispiel für einen Patienten für Bildungsinhalte — sollten immer überprüfen, was letztendlich kommuniziert wird. KI kann Texte sehr schnell und scheinbar effizient schreiben, aber nur ein Mensch kann das verantwortungsbewusst tun.

Die meisten verfügbaren KI-Modelle arbeiten außerhalb der EU und entsprechen nicht den Anforderungen der DSGVO. Das Senden medizinischer Daten an ein KI-Tool kann einen dauerhaften Verlust der Kontrolle darüber bedeuten. Und es sei daran erinnert, dass KI nicht versteht, was sensible Daten sind. Infolgedessen versteht er auch nicht, was es bedeutet, die Privatsphäre einer Person zu verletzen.

Sie hingegen handeln auf der Grundlage spezifischer Vorschriften, aber auch auf der Grundlage der Berufsethik. Sie wissen, dass Daten nicht nur Informationen sind — es sind die persönlichen Geschichten von Menschen, die Ihnen vertraut haben.

KI trägt niemals — egal wie stark entwickelt — keine rechtliche oder moralische Verantwortung. Auch wenn das Modell eine Handlung vorschlägt, die sinnvoll erscheint, sind Sie es, die die Entscheidung treffen — und Sie sind dafür gegenüber dem Patienten, dem Gesetz und der Berufsethik verantwortlich.

Der verantwortungsvolle Umgang mit KI bedeutet nicht nur, ihre Möglichkeiten zu kennen, sondern auch die Grenzen, deren Überschreitung den Patienten, den Arzt und die Beziehung zwischen ihnen gefährden kann.. Verantwortungsvoll eingesetzt, können sie Zeit sparen, Textanalysen unterstützen, die Kommunikation mit dem Patienten verbessern, es lohnt sich also, es zu verwenden für:

Gleichzeitig raten wir dringend davon ab, KI zu verwenden, um:

niem.png)

Ethische Risiken (wie Unzuverlässigkeit, mangelnde Rechenschaftspflicht, Voreingenommenheit bei der Algorithmusleistung oder Verstöße gegen den Datenschutz) sowie technische Risiken (wie Datenverlust, Verzerrung oder fehlender Zugriff) müssen unter Berücksichtigung der Bedürfnisse, der Sicherheit und der Verantwortung der Menschen angegangen werden [7].

Neue Technologien verändern die Medizin. Aber selbst das fortschrittlichste KI-Modell wird den Arzt nicht ersetzen. Weil die Unterschiede grundlegend sind.

KI wird besser, aber sie ersetzt keine Beziehungen. Er trifft keine Entscheidungen. Es hat keine Konsequenzen. Und er kennt Ihren Patienten nicht. Daher bleibt Ihre Rolle unersetzlich. KI kann deine Unterstützung sein und es lohnt sich, sie während deiner täglichen Praxis einzusetzen — aber nur, wenn du ihr aktiver Nutzer bleibst und kein passiver Empfänger bist. Wenn du sie wie jedes andere Tool nutzen kannst: mit Kompetenz, Verantwortung und einer gesunden Distanz.

deshalb Ihre Präsenz, Ihr Bewusstsein und Ihre Entscheidungen bleiben entscheidend. KI kann dein Assistent sein. Aber Sie sind der Autor und Führer in der Beziehung zum Patienten.

[1] Eysenbach G., The Role of ChatGPT, Generative Language Models, and Artificial Intelligence in Medical Education: A Conversation With ChatGPT and a Call for Papers, JMIR Med Educ 2023;9:e46885,, DOI: 10.2196/46885, https://mededu.jmir.org/2023/1/e46885

[2] E.J.T. is supported by NIH UM1TR004407 grant from the National Center for Advancing Translational Sciences. He is on the Dexcom board of directors and serves as an adviser to Tempus Labs, Illumina, Pheno.AI, and Abridge. [https://www.science.org/doi/10.1126/science.adk6139]

[3] Xiangxiang Zeng, Fei Wang, Yuan Luo, Seung-gu Kang, Jian Tang, Felice C. Lightstone, Evandro F. Fang, Wendy Cornell, Ruth Nussinov, Feixiong Cheng, Deep generative molecular design reshapes drug discovery, Cell Reports Medicine, Volume 3, Issue 12, 2022, 100794, ISSN 2666-3791, [https://doi.org/10.1016/j.xcrm.2022.100794.(https://www.sciencedirect.com/science/article/pii/S2666379122003494]

[4] Jiang, S., Hu, J., Wood, K. L., and Luo, J. (September 9, 2021). Data-Driven Design-By-Analogy: State-of-the-Art and Future Directions., ASME. J. Mech. Des. February 2022; 144(2): 020801. https://doi.org/10.1115/1.4051681

[5] Javaid, Abid Haleem, Ravi Pratap Singh, ChatGPT for healthcare services: An emerging stage for an innovative perspective, BenchCouncil Transactions on Benchmarks, Standards and Evaluations, Volume 3, Issue 1, 2023, 100105, ISSN 2772-4859, https://doi.org/10.1016/j.tbench.2023.100105, [https://www.sciencedirect.com/science/article/pii/S2772485923000224]

[6] Harrer S., Attention is not all you need: the complicated case of ethically using large language models in healthcare and medicine, BioMedicine, Volume 90, 104512, [https://www.thelancet.com/journals/ebiom/article/PIIS2352-3964(23)00077-4/fulltext]

[7] Chen Y., Esmaeilzadeh P., Generative AI in Medical Practice: In-Depth Exploration of Privacy and Security Challenges J Med Internet Res, 2024;26:e53008, doi: 10.2196/53008, PMID: 38457208, PMCID: 10960211, [https://www.jmir.org/2024/1/e53008/?utm]

[8] Zhang, P., & Kamel Boulos, M. N. (2023). Generative AI in Medicine and Healthcare: Promises, Opportunities and Challenges. Future Internet, 15(9), 286. https://doi.org/10.3390/fi15090286, [https://www.mdpi.com/1999-5903/15/9/286]

[9] Avram O, Durmus B, Rakocz N, Corradetti G, An U, Nitalla MG, Rudas A, Wakatsuki Y, Hirabayashi K, Velaga S, Tiosano L, Corvi F, Verma A, Karamat A, Lindenberg S, Oncel D, Almidani L, Hull V, Fasih-Ahmad S, Esmaeilkhanian H, Wykoff CC, Rahmani E, Arnold CW, Zhou B, Zaitlen N, Gronau I, Sankararaman S, Chiang JN, Sadda SR, Halperin E. SLIViT: a general AI framework for clinical-feature diagnosis from limited 3D biomedical-imaging data. Res Sq. 2023 Nov 21:rs.3.rs-3044914. doi: 10.21203/rs.3.rs-3044914/v2. Update in: Nat Biomed Eng. 2025 Apr;9(4):507-520. doi: 10.1038/s41551-024-01257-9. PMID: 38045283; PMCID: PMC10690310. [https://pmc.ncbi.nlm.nih.gov/articles/PMC10690310/]